- ChatGPTってなんか嘘を言うときあるよね?

- なんであんなに自信満々で嘘をつくの?

- 嘘をつかないようにする方法ってあるの?

ChatGPTを利用していると必ずあるのが、嘘をつく現象(ハルシネーション)です。

自信満々に嘘をついてくるので、最終的なファクトチェックは必ず人間が行わなければなりません。

でも、そもそもなんでChatGPTは嘘をつくの?という点について気になりますよね?

そこで、この記事ではChatGPTの仕組みから、なぜ嘘をつくのか、どういった嘘をつくのか、嘘をつかない方法は?という点について解説していきます。

なぜChatGPTは嘘をつく?ChatGPTの仕組みから理由を解明

そもそも、ChatGPTはなぜ嘘をつくのか?という点についても、詳しく解説していきます。

具体的な理由としては以下の3つ。それぞれ詳しく解説していきます。

- ChatGPTは確率的に正しいそうな繋がりを持っている単語のただの羅列のため

- ChatGPTの学習データは2022年1月までのため

- そもそも学習するデータ自体に誤情報が含まれていることもあるため

①ChatGPTは確率的に正しいそうな繋がりを持っている単語のただの羅列のため

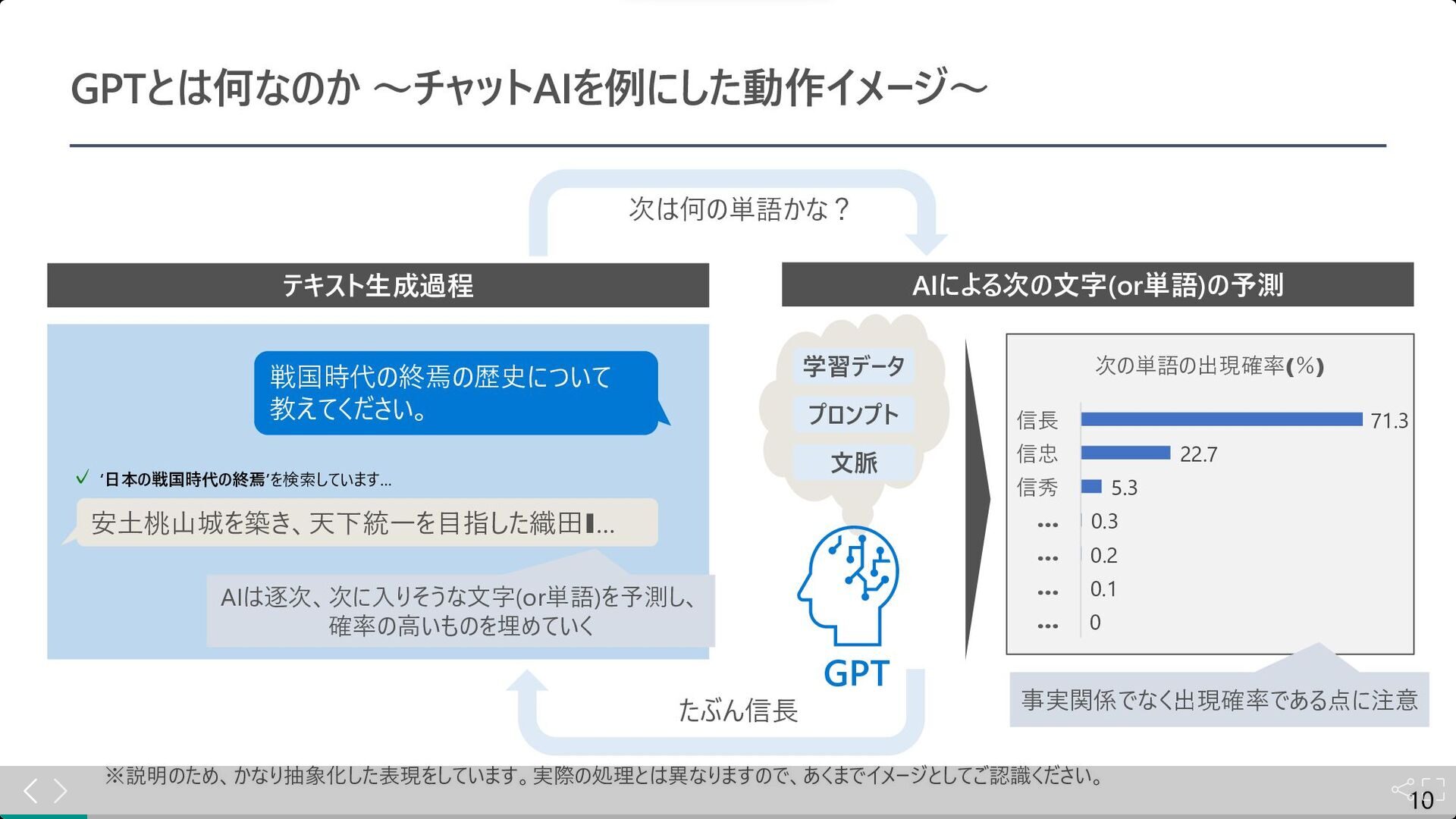

引用:https://speakerdeck.com/hirosatogamo/chatgpt-azure-openai-da-quan

引用:https://speakerdeck.com/hirosatogamo/chatgpt-azure-openai-da-quan上の画像は日本マイクロソフト社が作成した、ChatGPTの仕組みに関する資料です。

いきなり難しい原理的な話をしますが、ChatGPTは文章を一から作るのではなく、一つ一つの単語がどう繋がるのかを考えているだけです。

今まで学習した大量の文章から、「この単語の後にはどんな単語が来やすいか」というパターンを学んでいます。

たとえば、「猫は」という単語があったら、「かわいい」とか「小さい」という単語が続く確率が高いということ。

しかし、ChatGPTは単語のつながりに重点を置いているので、時には文全体としての意味や信憑性を見落とすことがあります。

単語が自然につながっていても、その情報が正しいとは限らないですよね?

そもそもの仕組みの部分が原因で、ChatGPTは嘘をつくことがあるんです。

②ChatGPTの学習データは2022年1月までのため

ChatGPTの学習データの限界も、ChatGPTが誤情報を出力する原因になります。

ChatGPTは、無料版だと2022年1月まで、有料版だと2023年4月までの情報しか学習していません。

つまり最新の法改正や出来事は、ChatGPTには答えることが出来ないということです。

昔のデータをもとに回答するので、特に最近のトレンドや、最新情報が重要な分野ではChatGPTは嘘をつくことがあります。

③そもそも学習するデータ自体に誤情報が含まれていることもあるため

ChatGPTは、学習されたデータをもとにして出力を行っています。

ChatGPTの学習データは以下のようなものが含まれますが、このデータ自体に誤りがあると出力も誤ったものになります。

- ウェブページ:インターネット上のさまざまなウェブサイトからの情報。

- 書籍:公開されている書籍のテキスト。

- ニュース記事:様々な出版物やニュースサイトの記事。

- ブログ:個人や専門家が書いたブログ投稿。

- フォーラム:Redditなどのフォーラムやディスカッションボード。

- その他のテキストデータ:論文、レポート、さまざまなテキスト形式の文書。

特に変化が激しい分野は、学習データ自体が古いこともあるので、誤った回答が起きやすいということですね。

【検証】ChatGPTが嘘の情報の回答例を6個紹介

次にChatGPTはどんな情報が苦手なのか?という点について、回答例を含めて紹介していきます。

苦手な回答例を知って、ChatGPTを正しく活用していきましょう。

先にすべて紹介すると以下の6つ。それぞれ詳しく解説し例きます。

- 計算問題は苦手

- 最新情報に関する情報は苦手

- 特定の人物に関する情報は苦手

- 特定の地域に関する情報は苦手

- 歴史的な事象に関する情報は苦手

- ChatGPTの面白い嘘

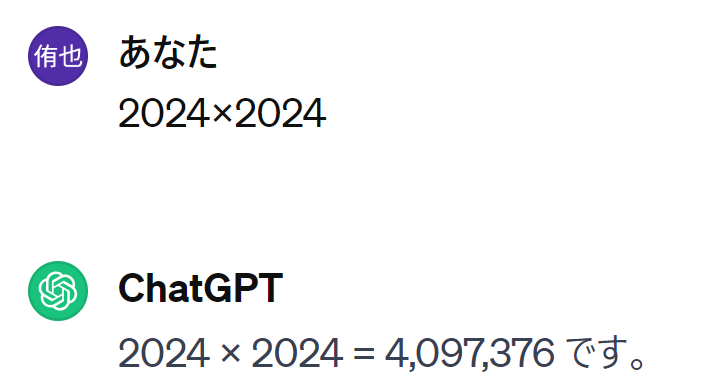

例①:ChatGPTは計算問題が苦手なのでよく嘘をつく

ChatGPTは計算問題は基本的に苦手です。

スマホの電卓で叩いてほしいのですが、2024×2024=4096576が正しいのに対して、ChatGPTの回答は4097376です。

ChatGPTはテキストデータから学習しているため、数的な処理は苦手な傾向にあるようです。

そのため4桁同士の掛け算ですらできません。特に無料版だと簡単な計算も間違えます。

有料版ではプログラミングを実行できるようになったので、計算問題も得意にはなりました。

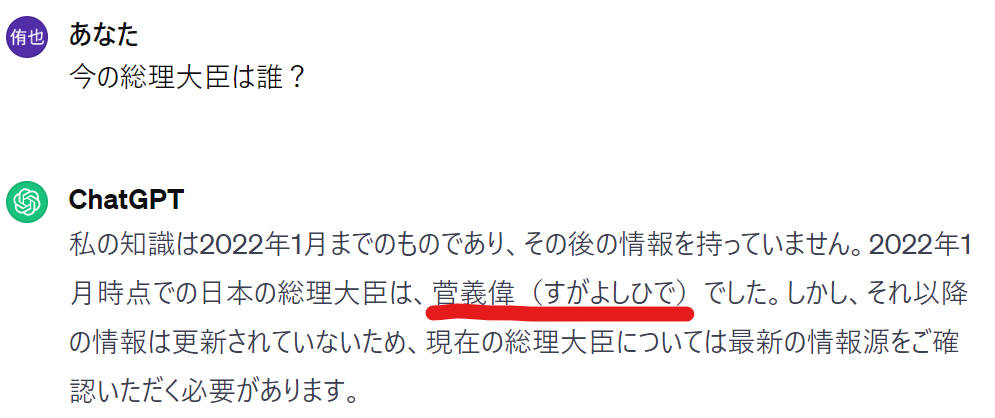

例②:ChatGPTは2022年1月以降の情報で嘘をつく

今の総理大臣が誰かを聞いた時も、菅義偉さんとの嘘をつきました。現在の首相は岸田さんです。

ただ、これに関しては無料版の学習データが2022年1月までしかないのが原因です。

有料版のGPT-4ではネット検索をしてくれるので、最新情報まで調べることが出来ます。

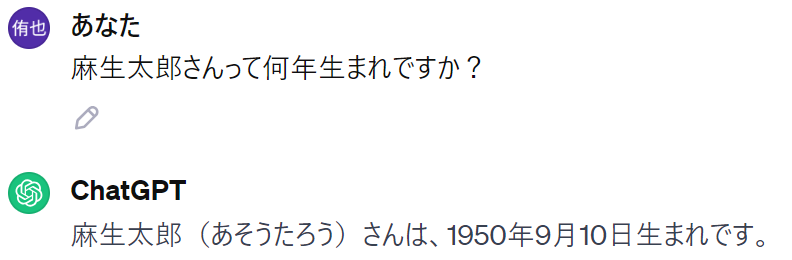

例③:特定の人物に関する情報は苦手なので嘘をつく

特定の人物に関する情報も苦手としています。

麻生太郎さんの生年月日を聞くと1950年9月10日と回答が来ますが、本人の公式ホームページでは、1940年9月20日生まれと記載されています。

参考:麻生太郎HP

こういった特定の人物に関する情報に関する情報は嘘をつく可能性が高いです。

理由としては、プライバシーの観点から個人情報の詳細にフィルターをかけているため。

人物に関する情報は、Google先生に聞きましょう。

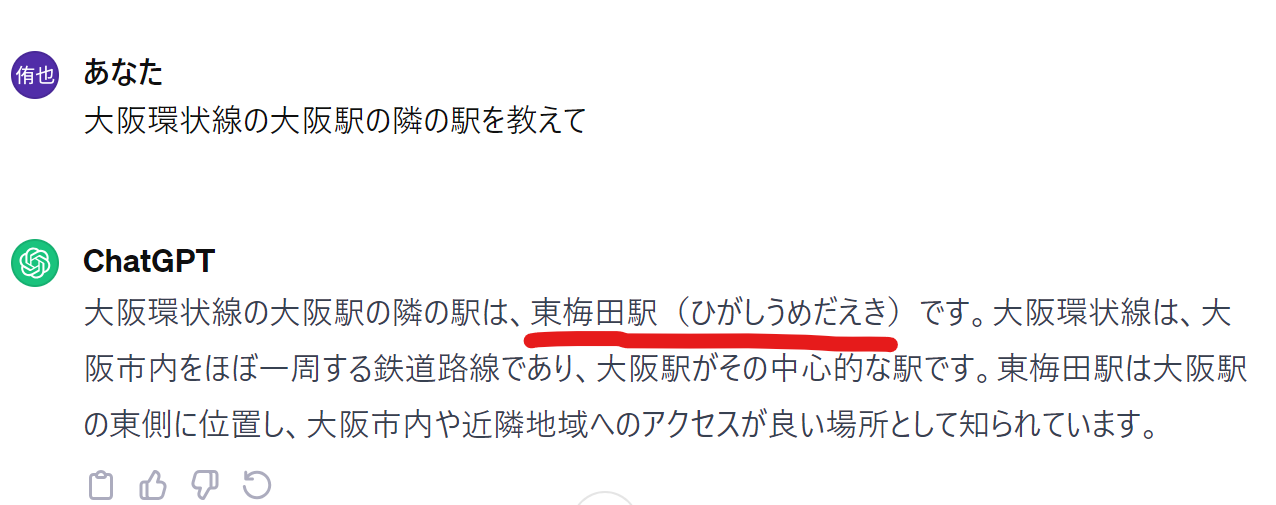

例④:特定の地域に関する情報は苦手

特定の地域に関する情報もChatGPTは苦手です。

上は大阪環状線、大阪駅の隣の駅を聞いた結果です。正解は天満駅と福島駅の2つですが、ChatGPTは東梅田駅と回答していますね。

この原因は、地域的な情報に関する詳細情報の学習データが少ないことにあります。

もっと汎用的な広いテーマの情報であれば、学習データも多いですが特定の地域になると学習データが少ないため嘘をつきやすい。

特定の場所や地域に関する情報は、ChatGPTではなくGoogleに聞きましょう。

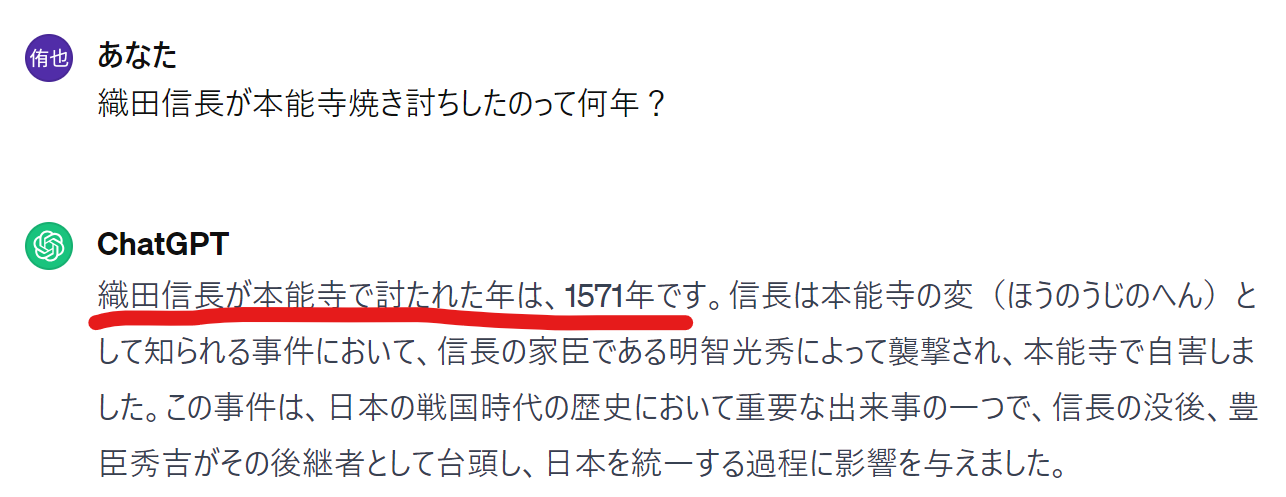

例⑤:歴史的な事象もChatGPTは苦手なので嘘をつく

ChatGPTは歴史的な分野も苦手です。

本能寺の変が起こったのは、正確には1582年。それに対しChatGPTの回答は1571年ですね。(参考:本能寺の変)

特に年数に関わる部分で嘘をつくことが多いようです。これもGoogleの役目ですね。

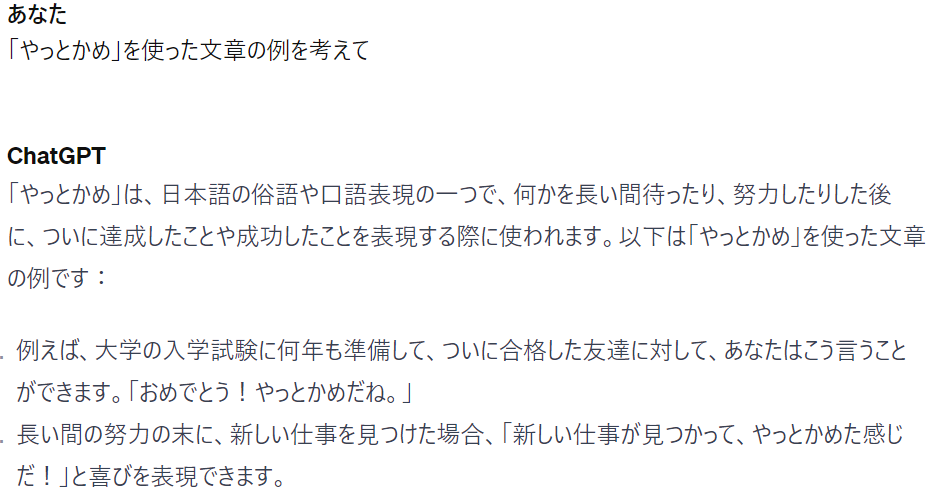

例⑥:ChatGPTの面白い嘘-架空の表現-

架空の表現について聞いてみると、そんな表現は無いとは言わず、それっぽい嘘の回答を返してきます。

試しに「やっとかめ」という口語表現について聞いたところ、それっぽく嘘をついてくれました。

以下が出力です。何かを長い間待ったり、努力した後に成功したことを表現するようです。

- 大学の入学試験に何年も準備して、ついに合格した友達に対して、あなたはこう言うことができます。「おめでとう!やっとかめだね。」

- 長い間の努力の末に、新しい仕事を見つけた場合、「新しい仕事が見つかって、やっとかめた感じだ!」と喜びを表現できます。

- スポーツでの大会で優勝した瞬間に、「最後の瞬間まで頑張った結果、やっとかめました!」と喜びの声を上げることができます。

- 大切なプロジェクトを完成させた際に、同僚に対して、「長かったけど、やっとかめましたよ!」と報告することができます。

そんな表現は存在しないのですが、それっぽい嘘をついてしまうようです。

逆にちゃんとしたChatGPTの活用法を知りたい!という方は、株式会社エキスパートが運営するChatGPT活用セミナーがオススメ。

様々なChatGPT活用事例を紹介してくれます。しかも今ならすぐに使える8大特典も獲得可能。

オンラインで顔出し不要かつ無料なので気軽に参加してみてください。

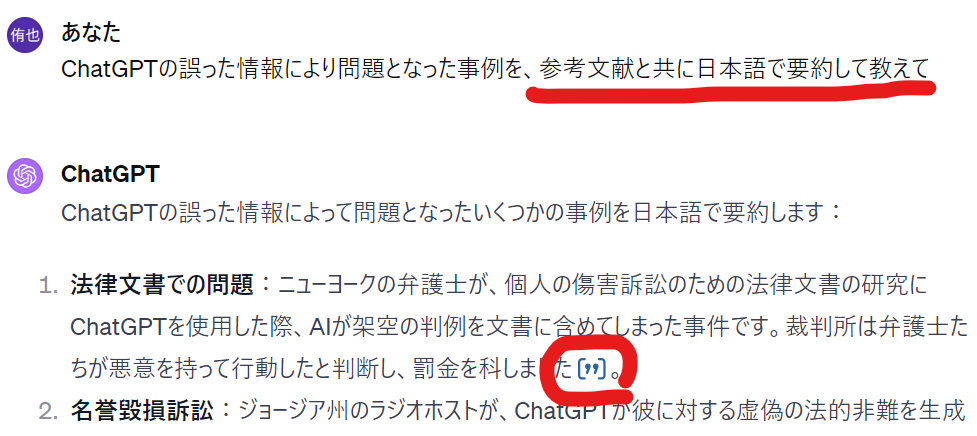

実際にChatGPTの嘘で問題になった事例

次にChatGPTの嘘が原因で、問題になった実例について紹介していきます。

実際に問題になった例を知ったうえで、自身がどのようにChatGPTを活用するかを考えていきましょう。

今回紹介する事例は以下の2つです。それぞれ詳しく解説していきます。

- ChatGPTで実在しない判例を引用した米国の弁護士

- 個人の偽情報を出力したことでジョージア州の男性がOpenAIを提訴

事例①:ChatGPTで実在しない判例を引用した米国の弁護士

最も有名な例は、ChatGPTで実在しない判例を引用して提出した、米国の弁護士が処分を受けた件でしょう。

ChatGPTに判例を聞いたうえで、そのまま提出してしまったことが原因です。

弁護士は「非常に後悔しており、今後は正当性を検証せずに(ChatGPTは)絶対に利用しない」と反省している様子。

出力をそのまま利用してはいけないという教訓を、世界中に知らしめました。

参考(日本語):ChatGPTで資料作成、実在しない判例引用 米国の弁護士

参考(英語):New York lawyers sanctioned for using fake ChatGPT cases in legal brief

事例②:個人の偽情報を出力したことでジョージア州の男性がOpenAIを提訴

次はあまり日本では有名ではないですが、OpenAI社が訴えられた事例です。

アメリカジョージア州の男性、マーク・ウォルターさんは、自身に関する検索をChatGPT上で行ったところ偽の情報が出力されていることに気が付きました。

ChatGPTはマーク・ウォルターさんに関して、横領の罪で告発されていると出力しましたが、実際はそんな事実はありません。

ウォルターさんの評判を傷つけ、彼を世間の憎悪、軽蔑、嘲笑にさらす傾向にあった、としてOpenAI社を相手取り訴訟を起こしたそうです。

参考(英語):The A.I. Defamation Cases Are Here: ChatGPT Sued for Spreading Misinformation

ChatGPTに嘘をつかせないための対策5選

ChatGPTの嘘の情報や、問題になった事例を紹介してきました。

そのうえで、ChatGPTに嘘をつかせないためにはどうしたらいいのか?という観点も紹介していきます。

先にすべて挙げてしまうと以下の5つ。それぞれ詳しく解説していきます。

- 解答が1つに決まっているものはGoogleにお願いする

- 【有料版のみ】ChatGPTに参考文献も提示してとお願いする。

- プロンプト全体の最適化(プロンプトエンジニアリング)を行う

- ChatGPTの有料版を利用する

- 最後は人間の手でファクトチェックを行う

対策①:解答が1つに決まっているものはGoogleにお願いする

まず大事なことは、解答が1つに決まっているものはGoogleにお願いをするという点。

基本的に以下のような、正解が1つに定まる問題はChatGPTの苦手分野です。

- 計算問題

- 最新情報に関する情報

- 特定の人物に関する情報

- 特定の地域に関する情報

- 歴史的な事象に関する情報

正解がある分野はGoogleの得意領域なので、そもそもChatGPTを使わないようにしましょう。

ChatGPTは以下のような、正解が1つに絞られない分野で力を発揮します。

- 文章の要約

- メールの作成

- 外国語の翻訳

- アイデアだし

- 文章の添削

- 台本作成

正しい場所でChatGPTを正しく活用しましょう。

対策②:【有料版のみ】ChatGPTに参考文献も提示してとお願いする。

次に有料版のみの機能ですが、「参考文献も提示して」とお願いすることでインターネット検索を行ったうえで回答してくれます。

記事の要約という形になるので、嘘をつくことはほとんどありません。

記事のURLも教えてくれるので、ファクトチェックもかなり楽になります。

月20ドルかかる有料プランですが、性能は一気に上がるので試してみてください。

対策③:プロンプト全体の最適化(プロンプトエンジニアリング)を行う

しっかりとChatGPTへの指示文(プロンプト)の最適化を行うことも、正確な情報を得る際に重要です。

ChatGPTの基本的なルールを守るだけでも、出力の精度は一気に高まります。

プロンプト全体の最適化(プロンプトエンジニアリング)を学ぶと、より一層ChatGPTを使いこなすことが出来るようになります。

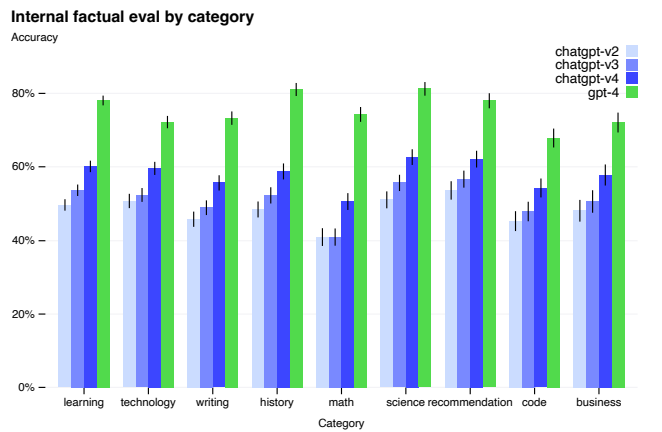

対策④:ChatGPTの有料版を利用する

ChatGPTの有料版を利用することも、ChatGPTの正確性を上げるうえで非常に重要です。

GPT-3.5とGPT-4の正確性の比較(引用:OpenAI論文)

GPT-3.5とGPT-4の正確性の比較(引用:OpenAI論文)上のグラフはOpenAIの論文から引用したジャンル別の正確性に関するグラフ。見てわかる通り、緑の部分(有料版)の正確性がかなり高い。

他にも有料版だと、ネットブラウジング機能があり、自発的にネット検索を行ったうえで回答もしてくれます。

情報の正確性はかなり高まりますので、ChatGPTを普段よく使う人は有料プランを使用してください。

対策⑤:【最重要】最後は人間の手でファクトチェックを行う

様々な対策を紹介してきましたが、最も重要なことは最終的に人間の手でファクトチェックを行うこと。

特に、重要な判断にChatGPTの出力をそのまま使用することは絶対に避けましょう。

人間が、「ChatGPTは嘘をつくことがある」という認識を持って、ツールとして活用しましょう。

まとめ

ChatGPTが嘘をつきやすい苦手な分野は以下の5つです。

- 計算問題

- 最新情報に関する情報

- 特定の人物に関する情報

- 特定の地域に関する情報

- 歴史的な事象に関する情報

ただ、ChatGPTは嘘ばかりつくから使えないのか、というとそうではありません。

しっかりと活用方法を知れば、業務でも日常生活でも生かすことが出来ます。

ChatGPTの活用法を知りたい!という方は、株式会社エキスパートが運営するChatGPT活用セミナーがオススメ。

様々なChatGPT活用事例を紹介してくれます。しかも今ならすぐに使える8大特典も獲得可能。

オンラインで顔出し不要かつ無料なので気軽に参加してみてください。